「ビックデータ同化」研究の衝撃!

今月で、経営コンサルタント兼行政書士として独立して、ちょうど2周年になりました。それまでは今風の表現で言えば、”シリアルアントレプレナー”ということになるのでしょうか、東京で2度の創業とM&Aを経験してきました。1社目はチャットボット開発で、2社目はAI開発のベンチャー企業でして、上場企業の株主らに支えられて、色んなことを学びながら経営をしておりました。

今月で、経営コンサルタント兼行政書士として独立して、ちょうど2周年になりました。それまでは今風の表現で言えば、”シリアルアントレプレナー”ということになるのでしょうか、東京で2度の創業とM&Aを経験してきました。1社目はチャットボット開発で、2社目はAI開発のベンチャー企業でして、上場企業の株主らに支えられて、色んなことを学びながら経営をしておりました。

これらの経験を踏まえ、独立に際しては「経営コンサルタント」と決めており、そのための武器の一つとして法律を選び行政書士資格を得たのですが、この時の目標は”福岡で企業の成長を支援する”というものでした。

そして自分自身で棚卸した私の強みは、「新規事業開発」「AI開発および導入」「資金調達」の3つに絞ってみたものの、個人の活動ではなかなか思うように行かず、これまでは「中期経営計画書策定」と「資金調達」がメインの業務でした。

いよいよ3年目に突入ですが、この春から働き方を変えて、行政組織に所属しながら、国の認定を受けた企業の経営支援をしたり、認定候補となる企業を発掘して支援したり、まさに私自身が希望したインキュベーションに関わる仕事を中心に取り組み始めました。現在の目標は、”九州から世界へ羽ばたく企業を支援する”と一気にグレードが上がったのですが、モデルケースの創出に向けて努力を続けたいと考えています。

前置きが長くなりましたが、このところベンチャー企業のプレゼンを聴く機会が多いのですが、「AI企業」と称するにはとてもお粗末な技術の会社のことが多く、もう逆に真剣に「AI」に取り組んでいるIT企業は「AI」と言わない方が良いのではないか、と思うようになってきました。

「AI」ではピンと来ないかも知れませんが、ロボットの事例だとわかりやすいかも知れません。NaoやPepperなどヒューマノイド・ロボットを開発したアルデバランロボティクス社も、産業用のアームロボットを開発するファナック社も、組み立てロボのロビを提供するディアゴステーニ社も、すべて「ロボット」を作る会社と呼称されてしまいます。今の「AI」を自称する会社のほとんどは、ロビくんに思えるということが言いたかったわけです。PepperのSDKキットを使って動かすことは、決してAI開発とは言えないと思うのは私だけではないと思います。わかりやすい単語で一括りにしてしまう社会の矛盾を今痛感しています。

先日「100年後の科学と社会を考える」シリーズと題したシンポジウムに参加する機会があり、数理・AIが解く未来!というテーマで、九大や理研の研究者の方のセッションを聴きました。どちらかというと創薬系の研究テーマが多く、「インシリコ創薬」というPCで作られる創薬の手法やアプローチについてのお話が多かったのですが、こちらは正直7割くらい理解できませんでした。

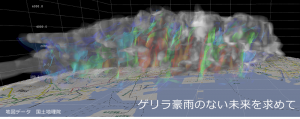

そしてタイトルにある「データ同化」という研究については、以前から概念だけは知っていて、気象や地震など予測が難しい分野での研究テーマだとの認識でした。しかし、理研の三好チームリーダーのお話を伺うにつれ、これはすごいことになる予感がして、まさに衝撃を受けたのです。

私は技術者でも研究者でもないので、正確にこの研究を理解した訳ではないと思いますが、事業開発という側面で理解した範囲で説明すると、「データ同化」とは、観測や実験から得られたデータと、予測されるシミュレーションを融合することによって、再現性を高めていき予測の精度を上げていくアプローチです。これが今のスパコン京の性能と、人工衛星の進化によって、ビックデータ同化へと進化しつつあります。この複雑な処理をなんと30秒に1回処理して、ゲリラ豪雨を予測しようとする試みでした。ホントにすごいことになっています。

AI技術については、実は50年以上前から研究されていて、私が会社を立ち上げた10年前に取り組んでいたソフト開発技術と、今実際にビジネスで活用されている技術は殆ど変わりません。しいて言えば、ニューラルネットのアプローチが少し変わって精度が上がったことですが、インプットデータがパターン化されたデータを機械学習する分野は確かに素晴らしい成果を上げていますが、断片的なデータや不規則な事象、変数が多いデータについては、どうしてもチューニングが必要となり、結果ベイズ理論に基づく確率論的アプローチやデータマイニングなど統計分析を採用せざるを得ず、今でも同様のようです。

一方で大きな変化を実感しているのは、様々なオープンソースが出てきて容易に開発ができる環境が整ってきたことと、半導体の進化によるスパコンの登場によって、ビックデータビジネスがすぐそこまで来ていることです。

インプットデータの種類や規則性、属性や構造などと、最終的にアウトプットする予測データの間には、必ずしも同じような属性や構造化されたものではないことが考えられます。過去の経験では、インプットデータから導きだされた、繰り返しのシミュレーションを時系列で重ねて学習することにより、データマイニング手法で解決しようとしていましたが、なかなか納得できる成果は得られませんでした。しかし、この「データ同化」の融合というアプローチが、この課題を解決してくれるのではないか、そんな風に私には思えました。

経営コンサルタントになってからは「AI」から少し距離を置いていたのですが、3年目のテーマの一つに「AI」を掲げ、もう少し勉強しながら企業支援に活かしていきたいと思いを新たにしている次第です。 ちなみにタイトルは「エクサスケール」をパクったのではなく、本当に衝撃を受けたからです。あしからず(;^_^A

福岡インキュベーションサポート

福岡インキュベーションサポート 行政書士中山小百合事務所

行政書士中山小百合事務所

初めてコメントします。

科学技術系のシミュレーションソフトを開発しています。所謂CAE業界の一員です。私もデータ同化には、非常に注目しており、機械系の製造業で是非使えるようにしたいと考えてますが、身近な所では、まだ余り取り沙汰されてはおりません。

コメント有難うございます!データ同化はまだ実用化のレベルに至ってないのでしょうか。お台場の産総研ではどうなのか、機会あれば聞いてみたいと思っています。私は行政機関に所属して、企業のプロジェクト開発を支援しているのですが、データ同化をテーマに取り組むのが夢の一つとなりました。しかし、製造業へ使えるようになると、すごいことになりそうです。何だかワクワクしますね。